Imaginemos este escenario totalmente futurista: una alianza encabezada por Estados Unidos dispuesta a erradicar al Estado Islámico (ISIS, por sus siglas en inglés) que está acercándose a Raqa.

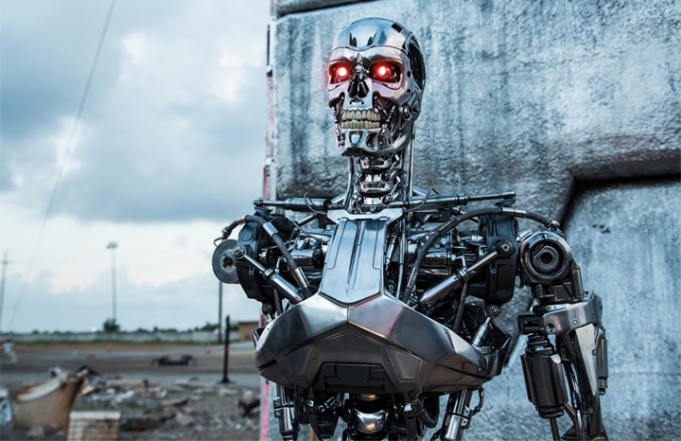

La fuerza militar internacional lanza un mortífero grupo de robots voladores que sobrevuelan la ciudad en busca del enemigo. Usando tecnología de reconocimiento facial, los robots localizan y aniquilan a los altos comandantes de ISIS, por lo que decapitan a la organización terrorista. Aturdido y desmoralizado, ISIS se desmorona con una pérdida mínima de vidas civiles y de tropas aliadas, relata John Thornhill en un artículo en The Wall Street Journal.

En ese caso, ¿quién pondría en duda el buen uso de la tecnología?

Al parecer, mucha gente que conoce la tecnología -incluyendo a numerosos expertos en inteligencia artificial- necesitaba desarrollar esas armas.

En una carta abierta publicada en julio del año pasado, un grupo de investigadores advertía que la tecnología estaba tan avanzada que el despliegue de Sistemas de Armas Autónomas Letales (Laws, por sus siglas en inglés) sería una realidad en cuestión de años, y no de décadas. A diferencia del armamento nuclear, estos sistemas podrían producirse en masa y en forma muy económica, convirtiéndose en los “Kalashnikov del mañana“.

“Será solo cuestión de tiempo para que aparezcan en el mercado negro y que caigan en manos de terroristas, de dictadores deseosos de controlar a sus ciudadanos y de caudillos que quieran hacer una limpieza étnica”, explicaban. “Empezar una carrera armamentística basada en la inteligencia artificial es una mala idea y debería evitarse prohibiéndose las armas autónomas ofensivas que escapan al control humano”.

Estados Unidos ya ha renunciado al uso de armamento autónomo ofensivo. Este mes, las Naciones Unidas organizó una ronda de conversaciones en Ginebra con 94 potencias militares con el objetivo de redactar un acuerdo internacional que limitara su uso.

El principal fundamento es de carácter moral: dar a los robots licencia para acabar con vidas humanas supone cruzar un límite que siempre debería respetarse.

Jody Williams, galardonada con el premio Nobel de la Paz por hacer campaña contra las minas antipersonales y vocera de la Campaña para detener a los robots asesinos, describió a las armas autónomas como más aterradoras que las armas nucleares. “¿A dónde vamos a llegar si pensamos que es correcto ceder el poder de decidir sobre la vida y la muerte a un robot?”, se preguntó.

Hay otras preocupaciones más allá de la cuestión puramente moral. ¿El uso de robots asesinos reduciría el número de bajas en una guerra si de ese modo aumenta las probabilidades de un conflicto? ¿Cómo podría evitarse la proliferación de este tipo de sistemas? ¿Quién sería responsable en el caso de que algo fallara?

Este argumento moral en contra de los robots asesinos queda lo suficientemente claro en un seminario de filosofía. El problema es que, cuanto más se analiza la posibilidad de su uso en el fragor de la guerra, más difícil resulta establecer los límites morales. Los robots (con una autonomía limitada) ya se han desplegado en el campo de batalla para fines muy concretos, como la desactivación de minas y los sistemas antimisiles. Todo apunta a que su uso tendrá un crecimiento exponencial.

El Centro para una Nueva Seguridad Norteamericana (CNAS, por sus siglas en inglés) calcula que el gasto global en robots militares alcanzará los u$s 7500 millones anuales hasta 2018, comparado con las previsiones de gasto de robots de uso industrial y comercial, que ascienden a u$s 43.000 millones.

El think-tank, que opera desde Washington, apoya el despliegue de estos sistemas, argumentando que pueden mejorar significativamente “la capacidad de aventajar a los adversarios”.

Con el lenguaje antiséptico que lo caracteriza, la industria armamentística hace una clara distinción entre los distintos niveles de autonomía. El primero, descripto como “humanos al tanto”, incluye a los drones depredadores muy utilizados por EE.UU. y otros ejércitos. Aunque un dron es capaz de identificar un objetivo, para activarlo es necesario que una persona presione un botón. Tal como se ve en la película Espías en el Cielo, esas decisiones pueden ser moralmente dolorosas, ya que implican hacer un equilibrio entre la importancia de atacar blancos vitales y el riesgo de que haya víctimas civiles.

En el segundo nivel de autonomía implica sistemas con “humanos al tanto”, donde personas supervisan sistemas de armas robotizadas, como la artillería antiaérea. Pero la velocidad y la intensidad de la guerra moderna son tales, que hay dudas sobre si la supervisión humana realmente se traduce en un control efectivo.

El tercer tipo, que corresponde al de los drones con plena autonomía, es potencialmente el más mortífero y probablemente el más fácil de prohibir.

Los investigadores especializados en inteligencia artificial deberían sin duda recibir un reconocimiento por haber sacado a la luz este debate. Los expertos en control armamentístico también están participando, pero con frustrante lentitud, de la tarea de definir y responder a este desafío. “Esta es una conversación valiosa,” dijo Paul Scharre, profesor en CNAS. “Pero es un proceso de pasmosa lentitud”.

Como en tantas áreas, nuestra sociedad todavía tiene que asimilar los impresionantes avances tecnológicos de los que está siendo testigo, por lo que poco puede controlarlos.